7 erreurs fatales de la sécurité IA en entreprise (et comment les corriger)

L'intelligence artificielle transforme le paysage professionnel, mais cette révolution s'accompagne de risques sécuritaires majeurs. Chaque jour, des entreprises exposent involontairement leurs données les plus sensibles à travers des erreurs de sécurité IA évitables. Découvrons ensemble les 7 erreurs fatales qui compromettent la protection des données d'entreprise et leurs solutions concrètes.

Erreur #1 : Utiliser des outils IA gratuits avec des données sensibles

Le problème critique

L'utilisation de ChatGPT gratuit ou d'autres solutions non sécurisées pour traiter des données clients représente la violation la plus courante en entreprise. Lorsque vos équipes copient-collent des informations sensibles dans ces outils publics, vos données migrent instantanément vers des serveurs étrangers et peuvent être réutilisées pour entraîner de nouveaux modèles d'IA.

Cette pratique expose l'entreprise à des amendes CNIL pouvant atteindre 20 000€ minimum, ou jusqu'à 4% du chiffre d'affaires annuel pour les violations graves du RGPD.

La solution immédiate

- Déployer une solution IA sécurisée et conforme RGPD avec garantie contractuelle de non-utilisation des données pour l'entraînement

- Interdire explicitement l'accès aux solutions IA publiques gratuites via les politiques d'entreprise

- Mettre en place un contrôle technique bloquant l'utilisation de ChatGPT et outils similaires sur les réseaux professionnels

- Former les équipes aux alternatives sécurisées disponibles

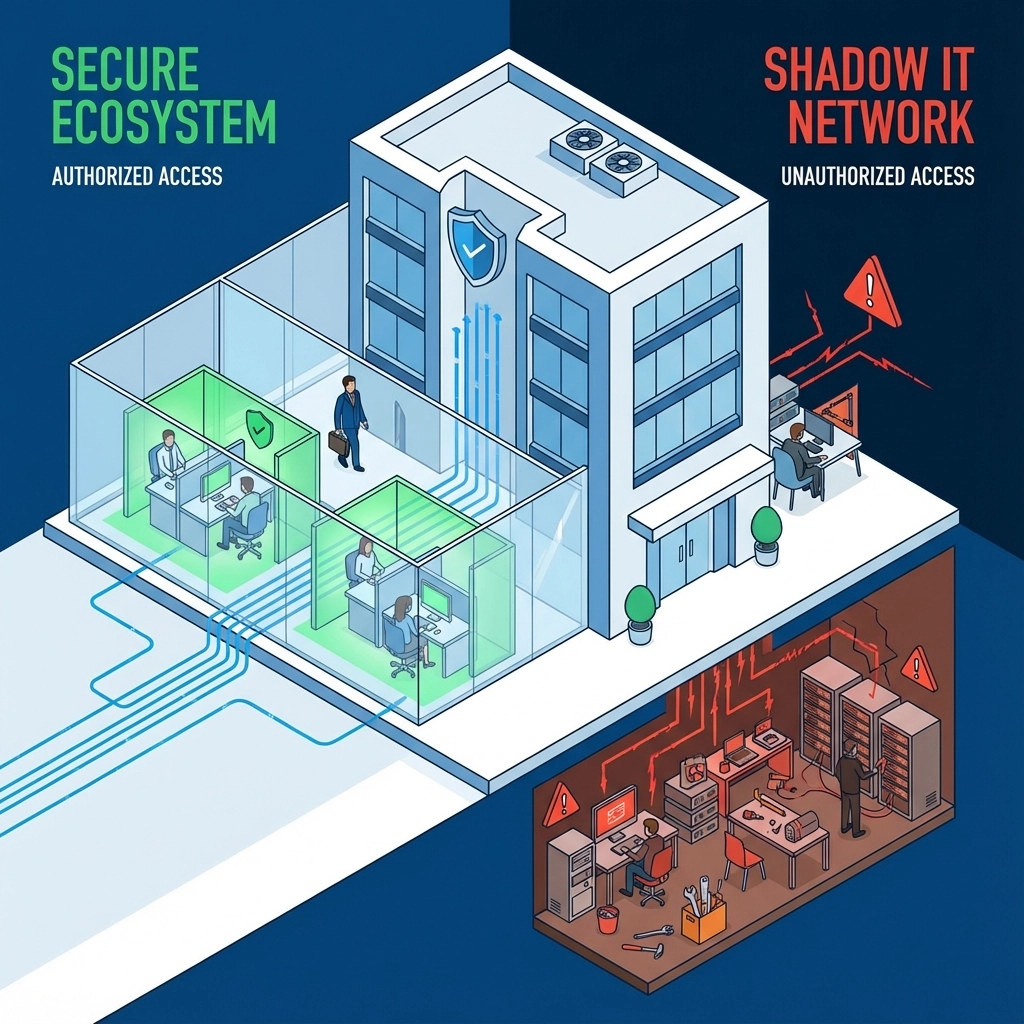

Erreur #2 : Ignorer le phénomène du Shadow IT

L'ampleur du problème

Face à l'absence de solution officielle, 42% des collaborateurs utilisent des outils IA personnels pour accélérer leur travail quotidien. Cette pratique contourne tous les contrôles de sécurité établis, créant un écosystème parallèle incontrôlable où les données confidentielles circulent sans aucune traçabilité.

Le Shadow IT IA représente un danger particulier car il combine facilité d'usage et puissance de traitement, rendant la tentation irrésistible pour les employés pressés d'améliorer leur productivité.

Comment reprendre le contrôle

- Proposer des solutions IA officielles accessibles et faciles d'utilisation qui rivalisent avec les outils gratuits

- Sensibiliser les équipes aux risques à travers une formation obligatoire incluant des cas concrets de violations

- Mettre en œuvre une gouvernance des accès avec authentification centralisée et monitoring

- Auditer régulièrement l'utilisation des outils IA par département pour identifier les usages non autorisés

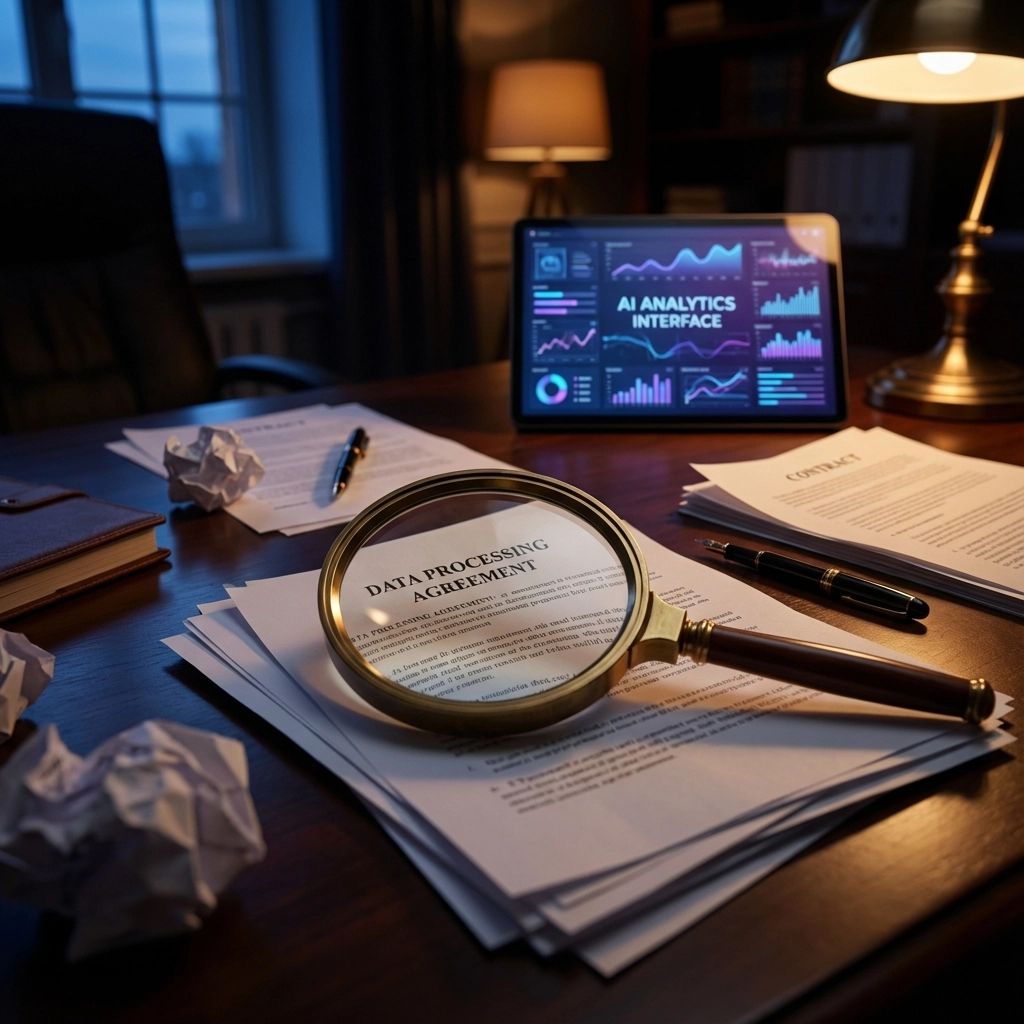

Erreur #3 : Négliger les accords de traitement des données (DPA)

Le piège contractuel

Sans Data Processing Agreement (DPA) explicite, votre fournisseur IA conserve le droit d'utiliser vos données pour entraîner ses modèles. Cette pratique constitue une violation directe du RGPD et expose l'entreprise à des sanctions réglementaires automatiques lors d'un contrôle.

La complexité réside dans le fait que de nombreux fournisseurs proposent des conditions générales ambiguës, laissant la porte ouverte à l'exploitation commerciale des données clients.

Sécuriser vos contrats

- Exiger un DPA explicite et détaillé avant tout engagement avec un fournisseur IA

- Faire valider chaque contrat par votre service juridique avec focus sur les clauses de confidentialité

- Documenter l'engagement contractuel du fournisseur à ne jamais utiliser vos données pour entraînement ou amélioration

- Vérifier les clauses de conformité RGPD et de géolocalisation des serveurs de traitement

Erreur #4 : Sous-estimer la complexité des données

La réalité cachée des projets IA

Les entreprises partent du principe que leurs données sont "propres et disponibles", mais découvrent trop tard qu'elles nécessitent des extractions complexes, des corrections manuelles massives et que les volumes exploitables sont insuffisants. Cette découverte tardive déstabilise l'ensemble du projet et multiplie les budgets par 3 à 5.

La qualité des données détermine directement la performance et la fiabilité des modèles IA. Des données biaisées ou incomplètes produisent des résultats incorrects qui peuvent impacter les décisions stratégiques de l'entreprise.

Anticiper les défis data

- Réaliser un audit complet des données avant le démarrage de tout projet IA

- Budgétiser 2x à 3x le temps initialement prévu pour la phase de préparation des données

- Documenter systématiquement la qualité : complétude, cohérence, représentativité et absence de biais

- Impliquer IT, métier, juridique et conformité RGPD dès la phase d'analyse des besoins

Erreur #5 : Négliger l'exposition des données par l'utilisateur

Le facteur humain : risque #1

L'erreur humaine représente la cause principale des violations de données dans les systèmes IA. Un analyste financier qui colle un rapport confidentiel dans une IA pour le résumer, ou un développeur qui partage un algorithme propriétaire pour déboguer constituent des cas réels observés quotidiennement en entreprise.

Ces actions, bien qu'innocentes dans l'intention, exposent des informations stratégiques à des tiers malveillants qui exploitent les prompts publics pour récupérer des données commerciales sensibles.

Éduquer et protéger

- Mettre en place une formation obligatoire sur les risques IA avant tout accès aux outils

- Créer un guide des bonnes pratiques détaillant quelles données peuvent être partagées et lesquelles sont strictement interdites

- Auditer régulièrement les usages et identifier les comportements à risque par département

- Utiliser des outils de contrôle de perte de données (DLP) pour bloquer automatiquement l'exfiltration de contenus sensibles

Erreur #6 : Oublier la gouvernance et la conformité

Les réglementations sectorielles

De nombreuses entreprises négligent les biais algorithmiques, les exigences sectorielles spécifiques (finance, santé, assurance) et les obligations de conformité évolutives. Un système IA techniquement performant mais non conforme peut être interdit de mise en production, anéantissant des mois d'investissement.

Les secteurs régulés imposent des contraintes particulières : traçabilité des décisions, audit humain obligatoire, respect de la diversité dans les échantillons d'entraînement.

Intégrer la conformité dès la conception

- Intégrer la conformité dès la phase de conception du projet IA, pas en fin de développement

- Auditer systématiquement les biais algorithmiques en testant sur des populations diversifiées

- Documenter chaque décision automatisée prise par le système pour assurer la traçabilité complète

- Respecter les exigences sectorielles : audit annuel, validation humaine, approbation réglementaire

- Créer un comité d'éthique IA multidisciplinaire incluant IT, métier, juridique et représentants utilisateurs

Erreur #7 : Négliger l'authentification et les autorisations

Les vulnérabilités d'accès

Des contrôles d'authentification et d'autorisation mal implémentés permettent aux attaquants d'accéder au modèle IA sous-jacent et aux données sensibles qu'il traite. Ces vulnérabilités subtiles peuvent permettre une exfiltration systématique de données à grande échelle, souvent indétectable pendant des mois.

L'attaque par détournement de session représente un risque particulièrement élevé dans les environnements IA où les sessions restent ouvertes longtemps pour traiter des volumes importants de données.

Blinder les accès

- Implémenter une authentification forte multi-facteurs pour tous les accès aux systèmes IA

- Appliquer rigoureusement le principe du moindre privilège : chaque utilisateur accède uniquement aux données nécessaires à sa fonction

- Mettre en œuvre un monitoring continu des accès avec alertes automatiques sur les comportements anormaux

- Chiffrer systématiquement les données en transit et au repos avec des clés rotatives

- Programmer des tests de pénétration des défenses trimestriels par des experts externes

- Déployer une couche de sécurité supplémentaire indépendante des protections du fournisseur

Plan d'action immédiat

Pour sécuriser efficacement vos projets IA, agissez sur trois horizons temporels :

Actions immédiates (0-30 jours) : Interdire l'utilisation d'outils IA gratuits avec données sensibles, lancer une formation de sensibilisation obligatoire, auditer les DPA existants.

Déploiement à moyen terme (1-6 mois) : Réaliser un audit qualité des données, identifier et stopper le Shadow IT, implémenter l'authentification multi-facteurs sur tous les systèmes.

Stratégie long terme (6-24 mois) : Créer une gouvernance IA formalisée avec comité dédié, auditer régulièrement les biais algorithmiques, investir dans une infrastructure de sécurité IA de niveau entreprise.

La sécurité IA n'est pas une option mais une nécessité stratégique. Chaque jour de retard expose votre entreprise à des risques croissants dans un environnement où les attaquants perfectionnent leurs techniques d'exploitation des vulnérabilités IA.

.png)

.png)

0 Commentaires